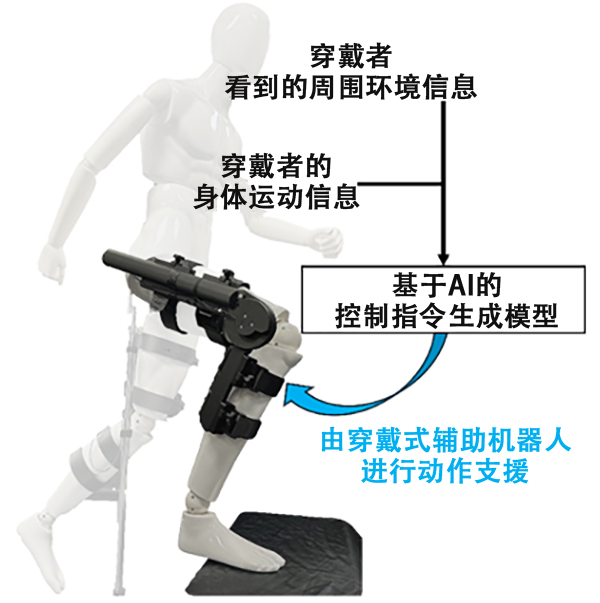

国立研究开发法人理化学研究所(简称“理研”)信息统合本部守护者机器人项目(GRP)人机协调研究团队的古川淳一朗(研究当时)研究员,以及森本淳客座主管研究员的研究团队,开发出了一种AI驱动型控制方法,可根据穿戴者的身体运动信息和第一人称视角影像,生成穿戴式运动助力机器人的控制指令(信号)。作为利用机器人的日常动作支援技术,该成果有望为日益加剧的老龄化社会做出贡献。相关研究成果已发表在《npj Robotics》上。

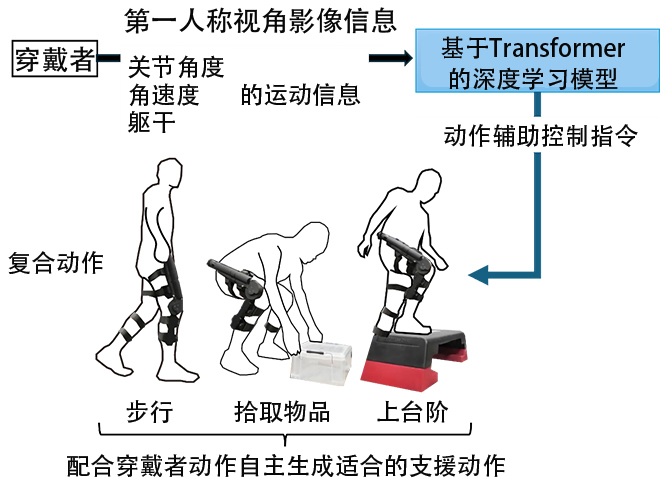

图1:基于AI驱动控制的助力机器人示意图(供图:理研)

研究团队探讨了将摄像机捕捉穿戴者周围环境的第一人称视角影像作为有用信息来源的可能性,并提出了一种控制方法,使穿戴式运动助力机器人能够准确估计穿戴者的意图并进行支援。

这种方法以第一人称视角拍摄的影像和由穿戴者的关节角度、角速度、躯干旋转运动信息构成的身体运动信息作为输入。基于这些信息,提出了一种基于Transformer架构的深度学习模型,用于输出穿戴式运动助力机器人的控制指令,从而生成支援动作的方法。该方法通过学习穿戴者周围环境与身体运动模式之间的相互关系,预测穿戴者的动作,实现自适应的辅助动作。其独特之处在于引入了第一人称视角影像,并且在无需使用棘手的生物信号的情况下控制了助力机器人。

图2:采用新方法的机器人系统动作支援示意图(供图:理研)

以第一人称视角影像和由穿戴者的关节角度、角速度、躯干旋转运动信息构成的身体运动信息作为输入;基于Transformer的深度学习模型生成适合动作及周围环境的动作辅助控制指令。实验中验证了由步行、拾取物品、上台阶等构成的复合动作。

该方法的验证通过两个阶段的实验进行。

实验中使用了与国际电气通信基础技术研究所(ATR)共同自主研发的穿戴式运动助力机器人。该机器人通过将气压人工肌肉致动器内置于碳树脂框架中,实现了超轻量化,即使在无控制状态下,佩戴者也能灵活运动。

第一阶段,让该穿戴式运动辅助机器人的穿戴者在无辅助动作控制的状态下,按任意顺序执行“步行”、“下蹲拾取地面物体”、“上台阶”等复合动作。同时拍摄此时的第一人称视角影像并测量关节角度、角速度、躯干旋转运动等身体运动信息,并让佩戴者通过手持按钮,在动作过程中随时标注其感觉到“需要辅助”或“不需要辅助”的区间。利用由此获得的第一人称视角影像、佩戴者的身体运动信息以及带有辅助需求标签的数据集,对新提出的方法模型进行了训练。

第二阶段,将基于第一阶段训练好的模型而实现的新方法,集成到穿戴式运动辅助机器人中,构建了机器人系统。在使用该机器人系统进行实时控制的动作辅助实验中,让运动辅助机器人的穿戴者按任意顺序执行相同的复合动作,以验证其方法的有效性。动作辅助的有效性通过测量实验参与者的肌肉活动和心率进行评估,而机器人辅助动作生成的精度则通过配备基于肌电图的传统方法进行比较来进行验证。

结果表明,与未穿戴机器人的情况相比,使用配备新方法的穿戴式运动辅助机器人进行辅助时,穿戴者的肌肉活动量有所减少。此外,将该机器人系统应用于新的实验参与者时,同样确认了肌肉活动量的减少。这表明该控制模型可能具备较高的泛化能力,能够高精度地适用于不同用户。

另一方面,在机器人辅助动作生成方面,也确认达到了与基于肌电图的传统方法同等或更高的精度。

尽管肌电图等生物信号传感器的可穿戴化日益进步,但其处理需要高度的专业性,并非易事。本次提出的方法,无需依赖生物信号传感器也能实现高精度辅助动作控制。由此,有望推动穿戴式运动辅助机器人自主控制技术的进步。

原文:《科学新闻》

翻译:JST客观日本编辑部

【论文信息】

期刊:npj Robotics

标题:Transformer-based multitask assist control from first-person view image and user's kinematic information for exoskeleton robots

DOI:10.1038/s44182-025-00033-4